Google stellt mit TranslateGemma offene Übersetzungsmodelle vor, bei denen ein 12-Milliarden-Parameter-Modell das doppelt so große Basismodell schlägt. Die Modelle unterstützen 55 Sprachen.

Google hat TranslateGemma in drei Varianten veröffentlicht: Das kleinste Modell mit 4 Milliarden Parametern ist für mobile Geräte optimiert, das 12B-Modell soll auf Consumer-Laptops laufen, das 27B-Modell ist für Cloud-Server gedacht und läuft auf einer einzelnen H100-GPU oder TPU.

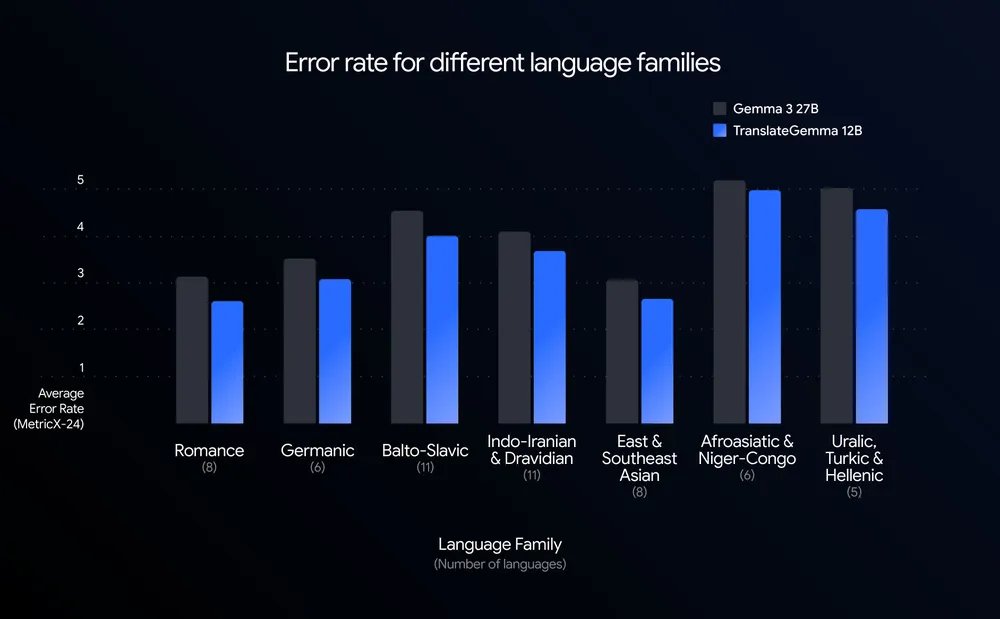

Die Qualität wurde mit MetricX gemessen, einer Metrik, die Übersetzungsfehler erfasst – niedrigere Werte bedeuten weniger Fehler. Das 12B-TranslateGemma erreicht einen Wert von 3,60 und übertrifft damit das 27B-Basismodell mit 4,04. Im Vergleich zum eigenen 12B-Basismodell (4,86) sank die Fehlerrate um rund 26 Prozent.

Das spezialisierte Modell TranslateGemma 12B erzielt bei Übersetzungen über alle untersuchten Sprachfamilien hinweg eine geringere Fehlerrate als das größere Gemma 3 27B-Modell. | Bild: Google

Das spezialisierte Modell TranslateGemma 12B erzielt bei Übersetzungen über alle untersuchten Sprachfamilien hinweg eine geringere Fehlerrate als das größere Gemma 3 27B-Modell. | Bild: GoogleDie Verbesserungen ziehen sich durch alle 55 evaluierten Sprachpaare. Besonders deutlich fallen die Gewinne bei ressourcenarmen Sprachen aus: Bei Englisch–Isländisch sinkt der Fehlerwert um mehr als 30 Prozent, bei Englisch–Swahili um rund 25 Prozent.

Gemini-Wissen in kleineren Modellen

Die Leistungssteigerung basiert auf einem zweistufigen Trainingsverfahren. Im ersten Schritt werden die Modelle mit menschlich übersetzten und synthetisch generierten Paralleldaten feinabgestimmt. Im zweiten Schritt optimiert ein Reinforcement-Learning-Verfahren die Übersetzungsqualität: Mehrere automatische Bewertungsmodelle prüfen die Ausgaben, ohne dass menschliche Referenzübersetzungen nötig sind. Ein zusätzliches Modell bewertet, ob die Texte natürlich klingen – also wie von Muttersprachlern verfasst.

Damit die Modelle trotz Spezialisierung vielseitig bleiben, enthält der Trainingsmix 30 Prozent allgemeine Anweisungsdaten. TranslateGemma kann daher auch als Chatbot Anweisungen befolgen.

Eine menschliche Evaluation mit professionellen Übersetzern bestätigt die automatischen Messungen weitgehend. Eine Ausnahme: Bei der Übersetzung von Japanisch nach Englisch zeigt TranslateGemma eine Verschlechterung, die laut Google auf Fehler bei Eigennamen zurückzuführen ist.

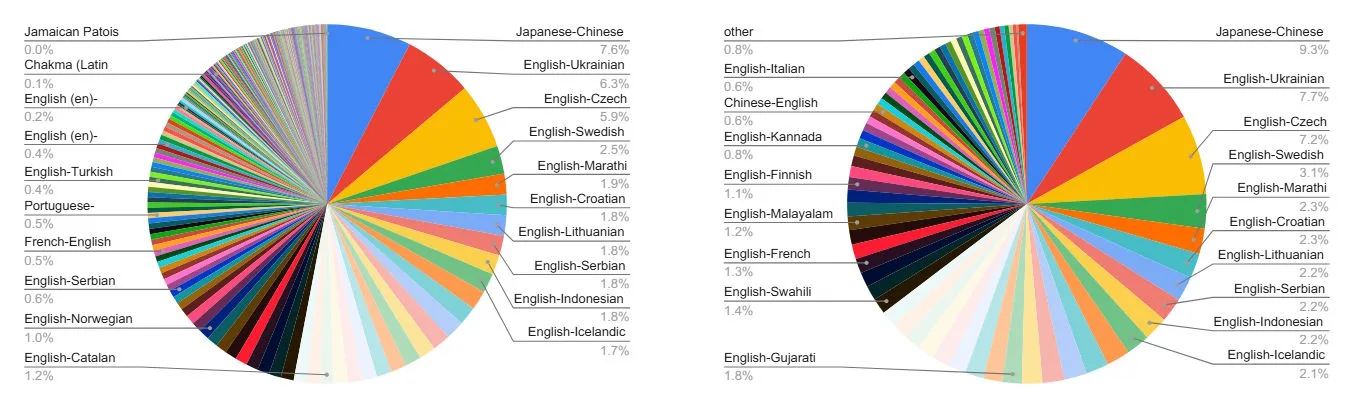

Die Trainingsdatenmischung für SFT und RL deckt 55 Sprachen ab. Besonders Sprachpaare wie Japanisch–Chinesisch und Englisch–Ukrainisch bilden Schwerpunkte bei der Optimierung. | Bild: Google

Die Trainingsdatenmischung für SFT und RL deckt 55 Sprachen ab. Besonders Sprachpaare wie Japanisch–Chinesisch und Englisch–Ukrainisch bilden Schwerpunkte bei der Optimierung. | Bild: GoogleMultimodale Fähigkeiten bleiben erhalten

Die Modelle behalten die multimodalen Fähigkeiten von Gemma 3: Sie können auch Text in Bildern übersetzen, obwohl sie dafür nicht speziell trainiert wurden. Tests auf dem Vistra-Benchmark zeigen, dass sich die Verbesserungen bei der Textübersetzung auch auf diese Aufgabe übertragen.

Für optimale Ergebnisse empfiehlt Google, das Modell mit einem speziellen Prompt als "professionellen Übersetzer" anzusprechen, der kulturelle Nuancen berücksichtigt. Die Modelle sind auf Kaggle und Hugging Face verfügbar.

TranslateGemma steht unter den Gemma Terms of Use, Googles hauseigener Lizenz für die Gemma-Modellfamilie. Diese erlaubt kommerzielle Nutzung, Modifikation und Weiterverteilung, verlangt aber die Weitergabe der Nutzungsbedingungen und verbietet bestimmte Anwendungen gemäß Googles Prohibited Use Policy. An den generierten Übersetzungen erhebt Google keine Rechte. Die Lizenz ist keine klassische Open-Source-Lizenz, da sie zusätzliche Einschränkungen enthält. Google spricht daher von "Open Weights".

Google baut Gemma-Familie weiter aus

Mit TranslateGemma baut Google seine Gemma-Familie weiter aus. Basis ist Gemma 3, das Google im Frühjahr 2025 als leistungsstarkes Open-Weights-Modell für Consumer-Hardware veröffentlichte. Darauf aufbauend sind inzwischen spezialisierte Varianten für verschiedene Einsatzbereiche entstanden: MedGemma für medizinische Bildanalyse, FunctionGemma für lokale Gerätesteuerung, Gemma 3 270M für ressourcenarme Umgebungen sowie Gemma 3n für mobile Geräte.

Im wachsenden Markt für offene Modelle positioniert sich Google damit gegen chinesische Konkurrenz: Im vergangenen Jahr haben Firmen wie Alibaba, Baidu und DeepSeek ihre Position deutlich ausgebaut, während US-Unternehmen wie OpenAI – das gerade erst mit ChatGPT Translate ein eigenes Übersetzungstool veröffentlicht hat – und Anthropic auf geschlossene Systeme setzen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.