Das Open-Source-Tool Ollama für die lokale Verwaltung von Large Language Models (LLM) liegt jetzt in Version 0.9.5 vor. Die Entwickler haben die Software laut eigener Aussagen grundlegend überarbeitet und bieten nun eine native macOS-Anwendung an, die sich durch schnellere Startzeiten und einen reduzierten Speicherbedarf auszeichnet. Der Umstieg von Electron auf eine native macOS-App macht sich direkt bemerkbar: Die Installationsgröße schrumpft um etwa 25 Prozent, während die Anwendung schneller startet.

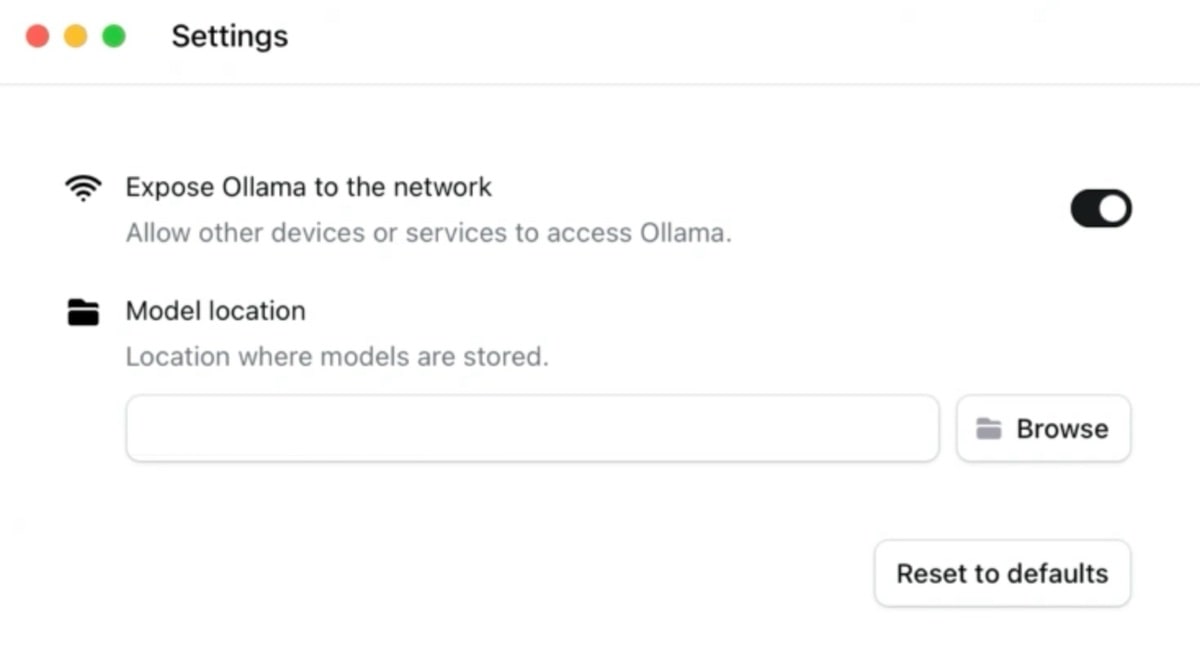

Mit Version 0.9.5 führt Ollama auch neue Funktionen ein. Über ein neues Einstellungsfenster lassen sich die verwalteten Sprachmodelle im Netzwerk freigeben. Dies ermöglicht es, ressourcenintensive LLMs auf leistungsstarken Rechnern laufen zu lassen, während andere Geräte im Netzwerk darauf zugreifen können. Die Modelle müssen auch nicht mehr im vorgegebenen Standardverzeichnis gespeichert werden, Nutzer können jetzt auch externe Speichermedien oder alternative Verzeichnisse wählen. Übrigens: Ollama gibt es auch für Windows und Linux, wir hatten hier schon einmal das Thema zum Einstieg.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

8 months ago

11

8 months ago

11