Um zu unterstreichen, wie groß die Nachfrage nach ihren Produkten ist, holte sich Lisa Su während ihres mehr als zweistündigen Auftritts auf der Technikmesse CES Verstärkung von Open AI . Die Vorstandschefin des Halbleiteranbieters Advanced Micro Devices (AMD) bat Greg Brockman auf die Bühne, einen der Mitgründer des ChatGPT-Entwicklers. „Jedes Mal, wenn ich Dich sehe, sagst Du mir, Du brauchst mehr Rechenleistung,“ sagte sie zu ihm.

Su warf selbst die in der Branche im Moment häufig gestellte Frage auf, ob den ganzen Investitionen in Infrastruktur für Künstliche Intelligenz (KI) auch eine entsprechende Nachfrage gegenüberstehe, und Brockman gab sich fest davon überzeugt. Open AI habe in den vergangenen Jahren jeweils seine Investitionen in Rechenkapazitäten verdreifacht, aber auch seine Umsätze. Jedes Mal, wenn das Unternehmen neue Produkte herausbringen wolle, gebe es einen internen Kampf um die begrenzten Kapazitäten. Brockman sagte, künftig könne das Wirtschaftswachstum in einzelnen Regionen der Welt davon abhängen, wie viel Rechenleistung dort verfügbar sei.

Fabriken als gigantische Roboter

Die Botschaft war unmissverständlich: Su und Brockman sehen die größte Herausforderung, wenn es um KI geht, nicht etwa in einer möglichen Blase, sondern in Engpässen in der Infrastruktur. „Wir haben nicht annähernd die Kapazitäten für alles, was wir tun könnten,“ sagte Su. KI sei „die wichtigste Technologie der vergangenen 50 Jahre“, und die Welt fange gerade erst an, die „Macht von KI“ zu erkennen. Ähnlich überschwängliche Töne hatte einige Stunden vor Su schon Jensen Huang angeschlagen, der Vorstandschef von Nvidia . Huang sprach von einer Zukunft, in der dank KI „jedes einzelne Auto und jeder einzelne Lastwagen“ autonom fahren könne und Fabriken „im Prinzip gigantische Roboter“ seien.

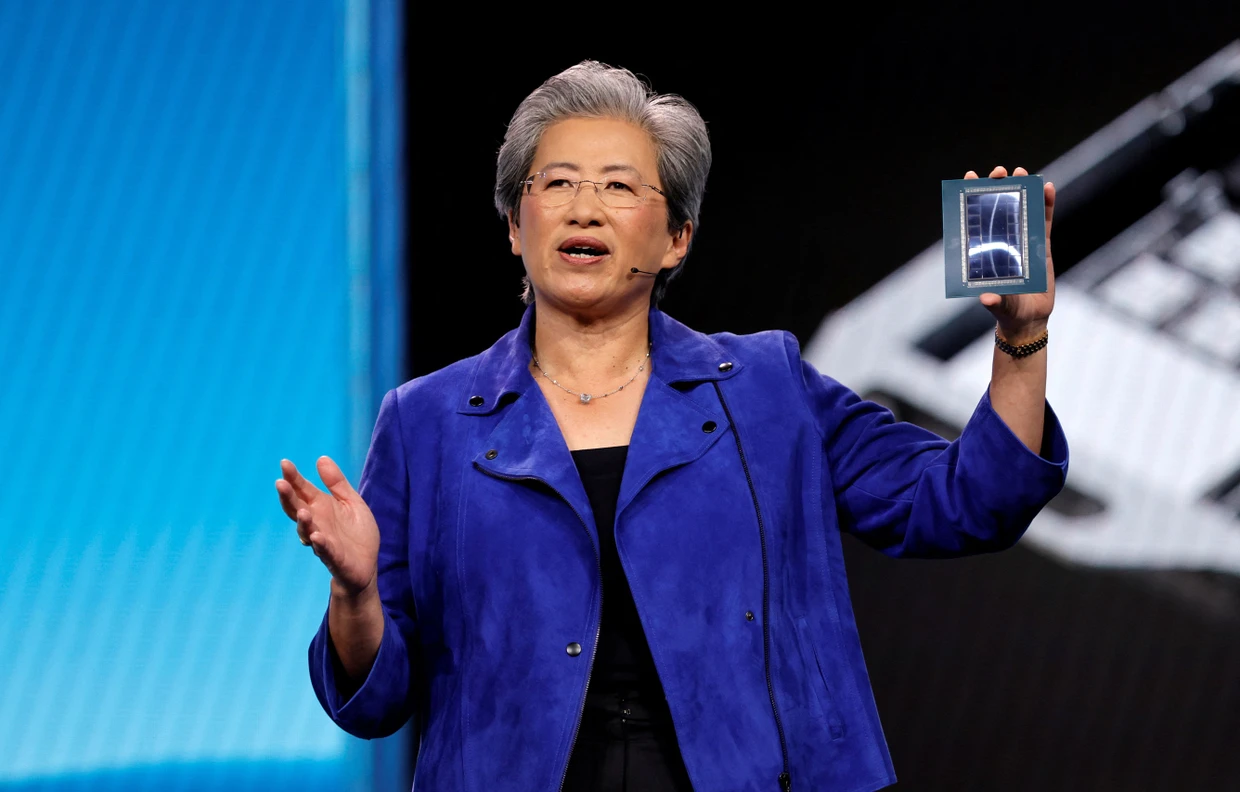

Lisa Su auf der CESReuters

Lisa Su auf der CESReutersDie Auftritte von Huang und Su waren mit Spannung erwartet worden. Der gegenwärtige Investitionsrausch rund um KI kommt vor allem den Chipanbietern zugute und hat sie in eine viel prominentere Position in der Branche gebracht. Nvidia hat bislang eine dominierende Position im Geschäft mit Chips für KI-Anwendungen und ist entsprechend der größte Gewinner. Im abgelaufenen Jahr stieg der Aktienkurs um fast 40 Prozent, nachdem er sich 2024 schon fast verdreifacht hatte. Als erstes Unternehmen überhaupt überquerte Nvidia im Herbst mit seinem Börsenwert die Marke von fünf Billionen Dollar, im Moment sind es knapp 4,6 Billionen Dollar.

In seinem jüngsten Geschäftsquartal hat das Unternehmen sein Wachstum noch einmal beschleunigt und den Umsatz um 62 Prozent auf 57 Milliarden Dollar gesteigert. Huang hat gesagt, Nvidia habe für die jüngsten Generationen seiner KI-Chips bis Ende nächsten Jahres Aufträge im Wert von 500 Milliarden Dollar.

Produktion von „Vera Rubin“ ist angelaufen

AMD ist unter den klassischen Halbleiterspezialisten derzeit der größte Herausforderer von Nvidia im Geschäft mit KI-Chips. Davon profitiert auch die Aktie. Im vergangenen Jahr stieg der Kurs um mehr als drei Viertel, die Marktkapitalisierung liegt bei mehr als 360 Milliarden Dollar. Su hat gesagt, AMD sei auf dem Weg dazu, 2027 einen Umsatz von mehreren zehn Milliarden Dollar mit solchen Chips zu erzielen. 2024 waren es noch rund fünf Milliarden Dollar. Damit liegt AMD freilich noch immer weit hinter Nvidia zurück. Sowohl Nvidia als auch AMD haben im vergangenen Jahr Partnerschaften mit Open AI geschlossen und beliefern das Unternehmen mit ihren Chips.

Huang sagte bei seinem Auftritt, die Produktion von Nvidias nächster Chiparchitektur mit dem Namen „Vera Rubin“ sei angelaufen. Das wurde in der Branche als wichtiges Signal gewertet, dass das Unternehmen im Plan liegt, die Chipreihe in diesem Jahr herauszubringen. Die neuen Chipsysteme sollen deutlich leistungsfähiger, aber billiger im Betrieb sein als die gegenwärtige Blackwell-Reihe.

Huang hob außerdem Allianzen mit deutschen Unternehmen hervor. Zum Beispiel sprach er über ein Bündnis mit Siemens rund um industrielle KI-Anwendungen und eine schon seit einigen Jahren bestehende Zusammenarbeit mit Mercedes-Benz. Der deutsche Autohersteller will noch in diesem Jahr eine Variante seines Modells CLA mit einem Fahrassistenzsystem von Nvidia herausbringen.

Neue Konkurrenz von Tech-Konzernen

Auch AMD-Chefin Su stellte einen neuen KI-Chip vor und gab einen Ausblick auf die nächste Chipgeneration MI500, die 2027 herauskommen soll. Sie werde tausendmal leistungsfähiger sein als die KI-Chips, die AMD 2023 eingeführt habe.

Nvidia und AMD sehen sich derzeit verstärkt Konkurrenz von anderer Stelle gegenüber. Einige ihrer wichtigsten Kunden, darunter Google, Amazon oder Microsoft, entwickeln auch ihre eigenen KI-Chips. Dies tun sie nicht zuletzt deshalb, um die bisherige Abhängigkeit von Nvidia zu reduzieren.

Besonders der Internetkonzern Google hat dabei in jüngster Zeit aufhorchen lassen. Seine KI-Chips sind als „Tensor Processing Units“ oder „TPUs“ bekannt. Er hat sie zunächst nur für hauseigene KI-Anwendungen entwickelt, seit einiger Zeit macht er sie in seinem Geschäft mit Cloud Computing auch externen Kunden zugänglich. Im Moment versucht er aber Medienberichten zufolge verstärkt, sie auch direkt an andere Unternehmen zu verkaufen, so wie dies Nvidia und AMD tun. Für Google ist dies eine von vielen KI-Initiativen. Der Konzern bringt auch eigene KI-Modelle heraus und konkurriert dabei mit Open AI, dem Entwickler von ChatGPT.