Die Macher von Home Assistant haben 2023 begonnen, verstärkt am Thema Sprachsteuerung zu arbeiten. Der Home Assistant soll sich per Sprache steuern lassen, hierbei greift man aber nicht auf Alexa oder den Google Assistant zurück. Die Plattform „Assist“ hat man mittlerweile sukzessive ausgebaut. Man unterstützt lokale Dienste sowie Clouddienste – inzwischen auch mit Home Assistant Voice auf dedizierter Hardware – zumindest im Preview-Stadium. Auch an der Anbindung von LLM, sprich künstlicher Intelligenz, arbeitet man.

Im Rahmen des Voice Chapter 11 informiert man über den derzeitigen Entwicklungsstand und weitere Planungen rund um das Thema Sprachsteuerung. Im Fokus steht derzeit die mehrsprachige Bedienung und man unterstützt einige Sprachen, welche Sprachassistenten der großen Tech-Giganten derzeit nicht unterstützen.

Bei Home Assistant hat man die Sprachunterstützung deutlich ausgeweitet. So unterstützt man mehrsprachige Haushalte mit der Möglichkeit, mit Assist in verschiedenen Sprachen zu interagieren. Seit einiger Zeit können Benutzer Assist-Sprachassistenten-Pipelines für verschiedene Sprachen in Home Assistant erstellen, aber die Interaktion mit den verschiedenen Pipelines erforderte entweder mehrere Sprachsatellitengeräte (eines pro Sprache) oder eine Art Automatisierungsauslöser, um die Sprache zu wechseln.

Mit 2025.10 werden bis zu zwei Wakewords und auch Pipelines für Sprachassistenten auf jedem Assist-Satelliten unterstützt. So kann das eine Aufwachwort für deutsche Sprachbefehle verwendet werden, während ein anderes Wakeword englischsprachige Befehle entgegennimmt. Möglich ist neben mehreren Sprachen auch die Unterscheidung und Trennung eines lokalen und eines Cloud-basierten Sprachassistenten bzw. (auf Wunsch) einem LLM.

Home Assistant hat neue Intents hinzugefügt. Drei neue sind es an der Zahl: Zur Steuerung von Medienplayern kann man jetzt die relative Lautstärke mit Sprachbefehlen wie „Lauter stellen“ oder „TV-Lautstärke um 25 % verringern“ einstellen. Dies ergänzt die bereits vorhandene Lautstärkeregelung, mit man absolute Lautstärke einstellen kann, z. B. „TV-Lautstärke auf 50 % einstellen“. Darüber hinaus ist es nun möglich, die Geschwindigkeit eines Lüfters prozentual einzustellen. Zum Beispiel: ‚Schreibtischlüfter auf 50 % einstellen‘ bzw. „Lüfter auf 50 % einstellen“, um alle Lüfter im aktuellen Bereich einzustellen. Mit den Intents lassen sich fortan auch Rasenmähroboter steuern, wie man das bereits von den Saugrobotern kennt.

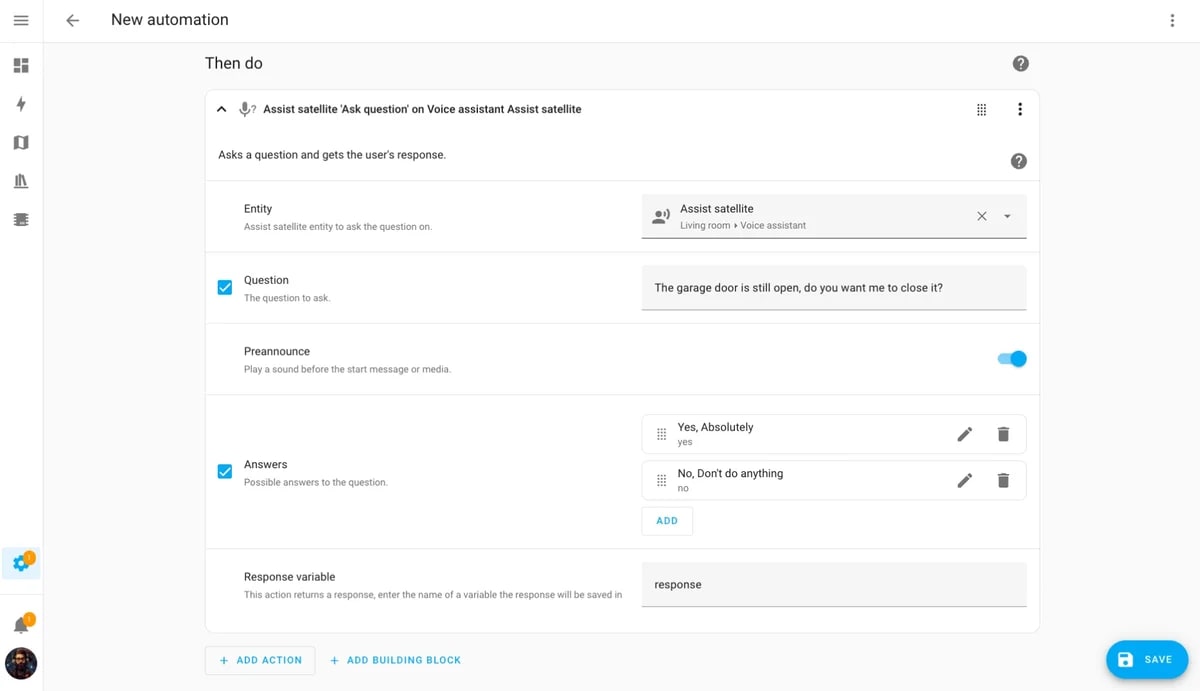

Mittels Automatisierungen – und ganz ohne LLM – kann Assist auch proaktiv Fragen stellen lassen. So ist es möglich beim Betreten des Wohnzimmers, gefragt zu werden, welche Art von Musik man bei der Zubereitung des Abendessens gerne hören möchte. Oder ob man das offengelassene Garagentor schließen möchte.

Assist wurde entwickelt, um schnell und vollständig offline auf Hardware wie dem Raspberry Pi 4 für viele verschiedene Sprachen zu laufen. Die Funktion gleicht den Text der Sprachbefehle mit Satzvorlagen ab, z. B. „Schalte {Name} ein“ oder „Schalte das Licht im {Bereich} aus“. Dies ist zwar sehr schnell und einfach in viele Sprachen zu übersetzen, kann aber auch unflexibel sein und zu Missverständnissen oder Fehlern führen. Mit dem verbesserten „Fuzzy Matcher“ soll das jetzt auch mit zusätzlichen Wörtern oder alternativen Formulierungen besser funktionieren. Vorerst in englischer Sprache, in Arbeit aber auch für weitere Sprachen.

Bisher quittiert Assist Sprachbefehle mit einer kurzen Bestätigung. Ab Home Assistant 2025.10 erkennt Assist, ob die Aktionen des Sprachbefehls alle im selben Bereich wie das Satellitengerät stattgefunden haben. Wenn dies der Fall ist, wird anstelle der vollständigen verbalen Antwort ein kurzer Ton zur Bestätigung abgespielt. Nonverbale Bestätigungen werden in Sprachassistenten-Pipelines mit LLMs nicht verwendet, da der Benutzer in seiner Eingabeaufforderung spezifische Anweisungen haben kann, wie z. B. „Reagiere wie ein Pirat“.

Bisher muss bei Verwendung von LLMs die vollständige Antwort abgewartet werden, bis diese per Text-to-Speech (TTS) ausgegeben wird. Bei umfangreichen Antworten bringt dies entsprechende Wartezeiten mit sich. Die TTS-Architektur hat man jetzt überarbeitet, um auch Streaming zu ermöglichen. Während Textabschnitte von einem LLM gestreamt werden, kann der TTS-Dienst Audioabschnitte synthetisieren und sie sofort zur Wiedergabe senden. Das TTS-Tool Piper unterstützt jetzt zudem mehr Stimmen sowie Sprachen.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

4 months ago

8

4 months ago

8