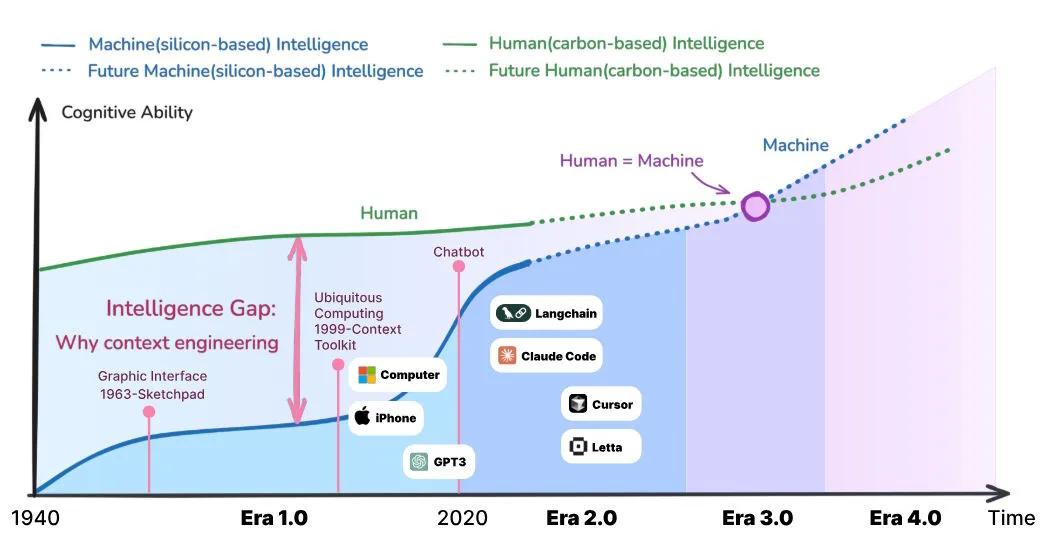

Die in Zukunft angeblich wachsende Lücke zwischen menschlicher (grün) und maschineller (blau) Intelligenz begründet laut den Forschenden die Notwendigkeit von Context Engineering, damit Maschinen menschliche Absichten besser verstehen. | Bild: Hua et al.

Die in Zukunft angeblich wachsende Lücke zwischen menschlicher (grün) und maschineller (blau) Intelligenz begründet laut den Forschenden die Notwendigkeit von Context Engineering, damit Maschinen menschliche Absichten besser verstehen. | Bild: Hua et al.Die dritte Stufe (Era 3.0) soll ein menschenähnliches Verständnis erreichen, einschließlich sozialer Hinweise und Emotionen. In der vierten Stufe (Era 4.0) würden Systeme Menschen sogar besser verstehen als diese sich selbst. Die Maschine würde dann nicht mehr nur reagieren, sondern aktiv neue Zusammenhänge aufzeigen. Ob diese Stufe überhaupt erreicht werden kann, jedenfalls mit aktueller Technologie, ist regelmäßig Gegenstand von Diskussionen in der KI‑Szene.

Zugleich verweisen die Forscher auf ein lange bekanntes Problem heutiger Sprachmodelle: Je mehr Kontext sie verarbeiten müssen, desto stärker sinkt ihre Leistung. Oft nimmt die Performance bereits ab, wenn das Gedächtnis zur Hälfte gefüllt ist.

Zudem wächst die Rechenzeit quadratisch: Eine doppelte Datenmenge bedeutet viermal so viel Aufwand. Das liegt an der Architektur: Transformer‑Modelle müssen jeden Informationsteil mit jedem anderen abgleichen. Bei 1.000 Tokens sind das etwa eine Million Vergleiche, bei 10.000 Tokens schon rund 100 Millionen.

Deshalb ist es bei der Nutzung von Sprachmodellen entscheidend, Quellen – etwa große PDFs – nicht einfach unstrukturiert in Chats zu werfen, sondern sie möglichst auf den relevanten Bereich zu begrenzen. Context-Engineering geht daher Hand in Hand mit Prompt-Engineering.

Das Semantic Operating System als Lösung

Ein Semantic Operating System soll diese Probleme lösen, indem es Kontext speichert und zudem aktiv verwaltet. Die Forscher beschreiben vier Kernfähigkeiten, die ein solches System haben müsste, um über Jahrzehnte hinweg kohärent zu bleiben, sich an neue Situationen anzupassen und dabei nutzbar für Menschen und Maschinen zu sein:

- Es muss großskalige semantische Speicherung unterstützen, wie eine eigene Gedächtnisbank, die Bedeutungen und Zusammenhänge statt nur Rohdaten erfasst.

- Es braucht menschenähnliche Gedächtnisverwaltung, also die Fähigkeit, aktiv Informationen hinzuzufügen, zu modifizieren und auch gezielt zu vergessen.

- Es benötigt neue Architekturen, die besser mit zeitlichen Abläufen umgehen können als heutige Transformer.

- Das System muss sich selbst erklären können, indem es jeden Schritt seiner Argumentation nachvollziehbar macht, korrigiert und interpretiert. Dies sei entscheidend für Vertrauen in praktischen Anwendungen.

Textuelle Kontextverarbeitung hat ihre Schwächen

Das Paper beschreibt verschiedene Methoden zur Verarbeitung textueller Kontexte, die jeweils spezifische Stärken und Schwächen aufweisen. Der einfachste Ansatz markiert jede Information mit einem Zeitstempel und bewahrt so die chronologische Reihenfolge.

Obwohl diese Methode bei Chatbots wegen ihrer Einfachheit beliebt ist, bietet sie keine semantische Struktur und führt bei wachsender Datenmenge zu erheblichen Skalierungsproblemen.

Ausgefeilter ist die Kategorisierung nach funktionalen Rollen wie "Ziel", "Entscheidung" oder "Aktion". Diese Struktur erleichtert zwar die Interpretation, kann jedoch zu starr für flexible Denkprozesse sein. Andere Ansätze reformulieren Kontext in Frage-Antwort-Paare oder organisieren Informationen hierarchisch von allgemeinen zu spezifischen Konzepten.

Beide Methoden haben jedoch ihre Grenzen: Frage-Antwort-Paare zerstören den ursprünglichen Gedankenfluss, während hierarchische Strukturen zwar Ideen klar präsentieren, aber wichtige logische Verbindungen und zeitliche Entwicklungen oft unberücksichtigt lassen.

Multimodale Herausforderungen

Moderne KI-Systeme müssen zunehmend verschiedene Datentypen gleichzeitig verarbeiten: Text, Bilder, Audio, Video, Code und Sensordaten. Die zentrale Herausforderung liegt in der grundsätzlichen Verschiedenheit dieser Modalitäten. Während Text diskret und sequenziell ist, sind Bilder hochdimensional und räumlich strukturiert, Audio hingegen kontinuierlich und zeitlich organisiert.

Die Forschenden identifizieren drei Hauptstrategien für die multimodale Verarbeitung. Der erste Ansatz projiziert alle Eingaben in einen gemeinsamen Vektorraum, wodurch semantisch verwandte Inhalte aus verschiedenen Modalitäten räumlich nahe positioniert werden.

Die zweite Methode kombiniert verschiedene Modalitäten in einem einzigen Transformer-System, wobei Text- und Bild-Token in jeder Schicht aufeinander achten können und detaillierte Querverbindungen entstehen.

Der dritte Ansatz nutzt Cross-Attention-Mechanismen, bei denen eine Modalität gezielt auf spezifische Teile einer anderen fokussiert. Im Gegensatz zum menschlichen Gehirn, das flexibel zwischen verschiedenen Sinneskanälen wechseln kann, erfordern diese technischen Systeme jedoch meist noch feste Zuordnungen zwischen den Modalitäten.

Ein zentrales Konzept für das Semantic Operating System nennen die Forschenden "Self-Baking". Damit meinen sie die Umwandlung von flüchtigen Informationen in dauerhafte, strukturierte Erinnerungen. Dies unterscheide bloßes Speichern von echtem Lernen.

Das Gedächtnis ist dabei in Schichten organisiert: Das kurzfristige Gedächtnis speichert aktuelle, relevante Informationen, das langfristige Gedächtnis bewahrt wichtige Muster über viele Sitzungen hinweg. Die Überführung geschieht durch Wiederholung und Wichtigkeit.

Vielversprechende Ansätze

Erste Schritte in Richtung Semantic Operating System zeigen sich bereits. Anthropics LeadResearcher speichert etwa Forschungspläne dauerhaft, selbst bei mehr als 200 000 verarbeiteten Token. Googles Gemini CLI nutzt das Dateisystem als leichtgewichtige Datenbank, eine zentrale Datei speichert Projekt-Hintergrund, Rollen und Konventionen, KI-generierte Zusammenfassungen komprimieren die Informationen in vordefinierte Formate. Alibabas Tongyi DeepResearch fasst gesammelte Informationen regelmäßig in einem "Reasoning State" zusammen. Nachfolgende Suchen bauen auf diesen Zwischenständen auf statt auf der kompletten Historie.

Brain-Computer-Interfaces könnten laut den Forschern die Kontext-Sammlung zukünftig revolutionieren. Sie könnten direkt erfassen, worauf jemand achtet, wie emotional eine Situation ist oder wie stark das Gehirn arbeitet. Dies erweitere die Erfassung von äußeren Handlungen hin zu inneren Gedanken und Gefühlen.

Kontext als neue Form der Identität

Die Wissenschaftler:innen ziehen aus ihrer technischen Vision eine philosophische Konsequenz. Sie berufen sich auf Karl Marx, der schrieb, dass „das menschliche Wesen“ durch seine sozialen Beziehungen bestimmt sei. Im Zeitalter der KI erhalte dieser Gedanke eine neue Bedeutung, so die Forschenden.

Menschen würden zunehmend durch die digitalen Spuren geprägt, die sie hinterlassen – durch ihre Gespräche, Entscheidungen und Interaktionen. „Der menschliche Geist kann vielleicht nicht hochgeladen werden, aber der menschliche Kontext schon“, schreiben sie. Gemeint ist damit, wie wir denken, entscheiden und kommunizieren. Diese Kontexte könnten über Generationen hinweg fortbestehen, sich weiterentwickeln und neue Einsichten hervorbringen.

Kontext würde so selbst zu einer dauerhaften Form von Wissen, Erinnerung und Identität. Digitale Spuren könnten weiterbestehen, sich verändern und sogar mit der Welt interagieren, lange nachdem eine Person nicht mehr existiert. Das Semantic Operating System bilde die technische Grundlage für diese Vision.