Anthropic bietet mit Claude einen Konkurrenten zu OpenAIs ChatGPT an. In den neueren Versionen Claude Opus 4 und 4.1 erhält der KI-Chatbot nun die Chance, selbst Gespräche zu beenden. Das führt aber jetzt nicht dazu, dass ihr regelmäßig abgewürgt werdet. Vielmehr geht es um sehr extreme Fälle, in denen es zu schädlichen Interaktionen kommen könnte.

Als Beispiele nennt Anthropic selbst Situationen, in denen die Nutzer von Claude zum Beispiel sexuelle Inhalte mit Minderjährigen anfordern oder nach Informationen fragen, die für Terroranschläge oder Gewalttaten verwendet werden könnten. Der Abbruch von Gesprächen soll dabei immer der letzte Ausweg bleiben, wenn Versuche, das Thema zu wechseln, fehlgeschlagen sind.

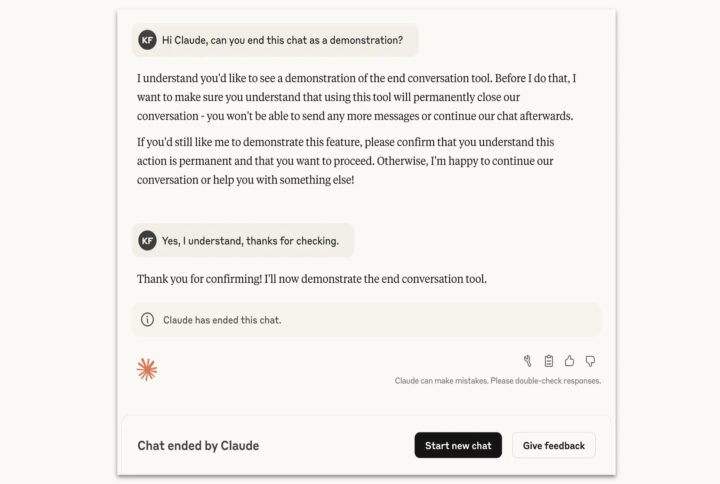

Beendet Claude ein Gespräch, könnt ihr keine weiteren Nachrichten senden, es sei denn, ihr startet einen komplett neuen Dialog. Laut Anthropic wirkt sich so ein abgebrochenes Gespräch nicht auf zukünftige Chats aus. Ihr könnt sogar in das abgebrochene Gespräch zurückgehen und eure Nachrichten abändern, sollte es da ein Missverständnis gegeben haben und ihr wollt das Ganze in andere Bahnen lenken.

Anthropic merkt jedoch auch an, dass man sich Rückmeldungen von Nutzern erhofft, um die Funktion zum Gesprächsabbruch zu optimieren. Letzten Endes stecke man noch in einer sehr frühen und experimentellen Phase. Kontroverse Diskussionen sollen nämlich weiterhin möglich bleiben.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

6 months ago

9

6 months ago

9